Los modelos de ecuaciones simultáneas son un tipo de modelo estadístico en forma de un conjunto de ecuaciones simultáneas lineales . Se utilizan a menudo en econometría . Uno puede estimar estos modelos ecuación por ecuación; sin embargo, los métodos de estimación que explotan el sistema de ecuaciones, como el método generalizado de momentos (GMM) y la estimación de variables instrumentales (IV), tienden a ser más eficientes .

Forma estructural y reducida [ editar ]

Supongamos que hay m ecuaciones de regresión de la forma

donde i es el número de la ecuación, y t = 1, ..., T es el índice de observación. En estas ecuaciones x que es la k i× 1 vector de variables exógenas, y que es la variable dependiente, y -i, t es el n i × 1 vector de todas las demás variables endógenas que entran en el i ésimo ecuación en la derecha lado, y T es son los términos de error. La notación “- i ” indica que el vector y −i, t puede contener cualquiera de los y's a excepción de y que (puesto que ya está presente en el lado izquierdo). Los coeficientes de regresión β i y γ i son de dimensiones k i × 1 y n i × 1 correspondientemente. Verticalmente apilado de las T observaciones correspondientes a la i º ecuación, podemos escribir cada ecuación en forma vectorial como

donde Y i y u i son T × 1 vectores, X i es un T × k i matriz de regresores exógenos, y Y -i es un T × n i matriz de regresores endógenos en el lado derecho de la i º ecuación . Finalmente, podemos mover todas las variables endógenas hacia el lado izquierdo y escribir las ecuaciones m conjuntamente en forma vectorial como

Esta representación se conoce como la forma estructural . En esta ecuación Y = [ y 1 y 2 ... y m ] es la matriz de variables dependientes T × m . Cada una de las matrices Y -i es de hecho un n i -columned submatriz de esta Y . La matriz m × m Γ, que describe la relación entre las variables dependientes, tiene una estructura complicada. Tiene unos en la diagonal, y todos los demás elementos de cada columna i son los componentes del vector −γ io ceros, dependiendo de qué columnas de Y se incluyeron en la matriz Y −i . La matriz X de T × k contiene todos los regresores exógenos de todas las ecuaciones, pero sin repeticiones (es decir, la matriz X debe ser de rango completo). Así, cada X i es un k i -columned submatriz de X . La matriz Β tiene un tamaño k × m , y cada una de sus columnas consta de los componentes de los vectores β i y los ceros, según cuál de los regresores de X se incluyó o excluyó de X i . Por último, u= [ u 1 u 2 ... u m ] es una matriz T × m de los términos de error.

Después de multiplicar la ecuación estructural por Γ −1 , el sistema puede escribirse en forma reducida como

Este ya es un modelo lineal general simple , y puede estimarse, por ejemplo, por mínimos cuadrados ordinarios . Lamentablemente, la tarea de descomponer la matriz estimada.en los factores individuales Β y Γ −1 es bastante complicado, y por lo tanto la forma reducida es más adecuada para la predicción pero no para la inferencia.

Suposiciones [ editar ]

En primer lugar, el rango de la matriz X de los regresores exógenos debe ser igual a k , tanto en muestras finitas como en el límite como T → ∞ (este último requisito significa que en el límite la expresióndebe converger a una matriz kx k no degenerada ). También se supone que la matriz be no es degenerada.

En segundo lugar, se supone que los términos de error son independientes en serie y distribuidos de manera idéntica . Es decir, si la fila t th de la matriz U se denota por u ( t ) , entonces la secuencia de los vectores { u ( t ) } debe ser iid, con media cero y alguna matriz de covarianza Σ (lo cual es desconocido). En particular, esto implica que E [ U ] = 0 , y E [ U′U ] = T Σ .

Por último, las condiciones de identificación requieren que el número de incógnitas en este sistema de ecuaciones no exceda el número de ecuaciones. Más específicamente, la condición de orden requiere que para cada ecuación k i + n i ≤ k , que se puede expresar como "el número de variables exógenas excluidas es mayor o igual al número de variables endógenas incluidas". La condición del rango de identificabilidad es ese rango (Π i 0 ) = n i , donde Π i 0 es a ( k - k i ) × n i matriz que se obtiene de Π al tachar aquellas columnas que corresponden a las variables endógenas excluidas y aquellas filas que corresponden a las variables exógenas incluidas.

Estimación [ editar ]

Mínimos cuadrados de dos etapas (2SLS) [ editar ]

El método de estimación más simple y más común [2] para el modelo de ecuaciones simultáneas es el denominado método de mínimos cuadrados en dos etapas , desarrollado independientemente por Theil (1953) y Basmann (1957) . Es una técnica de ecuación por ecuación, donde los regresores endógenos en el lado derecho de cada ecuación están siendo instrumentados con los regresores X de todas las demás ecuaciones. El método se llama "dos etapas" porque realiza la estimación en dos pasos: [3]

- Paso 1 : Regresa Y −i en X y obtén los valores predichos;

- Paso 2 : estimar γ i , β i mediante la regresión de mínimos cuadrados ordinarios de y i eny X i .

Si el i ª ecuación en el modelo se escribe como

donde Z i es un T × ( n i + k i ) matriz de ambos regresores endógenos y exógenos en el i ésimo ecuación, y δ i es un ( n i + k i ) vectores -dimensional de coeficientes de regresión, entonces el estimador MC2E de δ se me dará por [3]

donde P = X ( X ' X ) -1 X ' es la matriz de proyección sobre el espacio lineal abarcado por los regresores exógenos X .

Mínimos cuadrados indirectos [ editar ]

Mínimos cuadrados indirectos es un enfoque en econometría donde los coeficientes en un modelo de ecuaciones simultáneas se estiman a partir del modelo de forma reducida utilizando mínimos cuadrados ordinarios . [4] [5]Para esto, el sistema estructural de ecuaciones se transforma primero en la forma reducida. Una vez que se estiman los coeficientes, el modelo vuelve a la forma estructural.

Máxima verosimilitud de información limitada (LIML) [ editar ]

El método de máxima verosimilitud de "información limitada" se sugirió a MA Girshick en 1947, [6] y fue formalizado por TW Anderson y H. Rubin en 1949. [7] Se usa cuando uno está interesado en estimar una sola ecuación estructural a la vez ( de ahí su nombre de información limitada), digamos para observación i:

Las ecuaciones estructurales para las restantes variables endógenas Y −i no están especificadas, y se dan en su forma reducida:

- : La (s) variable (s) endógena (s).

- : La (s) variable (s) exógena (s)

- : El instrumento (s) (a menudo denotado) )

La fórmula explícita para el LIML es: [8]

donde M = I - X ( X ′ X ) −1 X ′ , y λ es la raíz característica más pequeña de la matriz:

donde, de manera similar, M i = I - X i ( X i ′ X i ) −1 X i ′ .

En otras palabras, λ es la solución más pequeña del problema del valor propio generalizado , ver Theil (1971 , p. 503):

Estimadores de la clase K [ editar ]

El LIML es un caso especial de los estimadores de clase K: [9]

con:

Varios estimadores pertenecen a esta clase:

- κ = 0: OLS

- κ = 1: 2SLS. Tenga en cuenta que en este caso, La matriz de proyección habitual del 2SLS.

- κ = λ: LIML

- κ = λ - α (nK): estimador de Fuller (1977) . Aquí, K representa el número de instrumentos, n el tamaño de la muestra y α es una constante positiva para especificar. Un valor de α = 1 producirá un estimador que es aproximadamente imparcial. [10]

Mínimos cuadrados de tres etapas (3SLS) [ editar ]

El estimador de mínimos cuadrados de tres etapas fue introducido por Zellner y Theil (1962) . [11] Se puede ver como un caso especial de GMM de múltiples ecuaciones donde el conjunto de variables instrumentales es común a todas las ecuaciones. [12] Si todos los regresores están predeterminados, 3SLS se reduce a regresiones aparentemente no relacionadas (SUR). Por lo tanto, también puede verse como una combinación de mínimos cuadrados de dos etapas (2SLS) con SUR.

Uso de restricciones de ecuaciones cruzadas para lograr la identificación [ editar ]

En los modelos de ecuaciones simultáneas, el método más común para lograr la identificación es imponer restricciones de parámetros dentro de la ecuación. [13] Sin embargo, la identificación también es posible mediante restricciones de ecuaciones cruzadas.

Para ilustrar cómo se pueden usar las restricciones de ecuaciones cruzadas para la identificación, considere el siguiente ejemplo de Wooldridge [13]

y 1 = γ 12 y 2 + δ 11 z 1 + δ 12 z 2 + δ 13 z 3 + u 1

y 2 = γ 21 y 1 + δ 21 z 1 + δ 22 z 2 + u 2

donde z's no están correlacionados con u's y y's son variables endógenas . Sin más restricciones, la primera ecuación no se identifica porque no hay una variable exógena excluida. La segunda ecuación se identifica solo si δ 13 0, que se supone que es cierto para el resto de la discusión.

Ahora imponemos la restricción de la ecuación cruzada de δ 12 = δ 22 . Dado que se identifica la segunda ecuación, podemos tratar δ 12 como se conoce con el propósito de identificación. Entonces, la primera ecuación se convierte en:

y 1 - δ 12 z 2 = γ 12 y 2 + δ 11 z 1 + δ 13 z 3 + u 1

Luego, podemos usar (z 1 , z 2 , z 3 ) como instrumentos para estimar los coeficientes en la ecuación anterior, ya que hay una variable endógena (y 2 ) y una variable exógena excluida (z 2 ) en el lado derecho. Por lo tanto, las restricciones de ecuación cruzada en lugar de las restricciones dentro de la ecuación pueden lograr la identificación.

Aplicaciones en ciencias sociales [ editar ]

En todos los campos y disciplinas, los modelos de ecuaciones simultáneas se aplican a diversos fenómenos observacionales. Estas ecuaciones se aplican cuando se asume que los fenómenos son recíprocamente causales. El ejemplo clásico es la oferta y la demanda en economía . En otras disciplinas hay ejemplos como las evaluaciones de candidatos y la identificación de partidos [14] o la opinión pública y la política social en ciencias políticas ; [15] [16] inversión vial y demanda de viajes en geografía; [17] y el logro educativo y la entrada de la paternidad en sociología o demografía . [18]El modelo de ecuación simultánea requiere una teoría de causalidad recíproca que incluya características especiales si los efectos causales se estiman como retroalimentación simultánea en oposición a los 'bloques' unilaterales de una ecuación donde un investigador está interesado en el efecto causal de X en Y mientras se mantiene constante el efecto causal de Y en X, o cuando el investigador sabe la cantidad exacta de tiempo que toma para que tenga lugar cada efecto causal, es decir, la duración de los retrasos causales. En lugar de efectos retardados, la retroalimentación simultánea significa estimar el impacto simultáneo y perpetuo de X e Y entre sí. Esto requiere una teoría de que los efectos causales son simultáneos en el tiempo, o tan complejos que parecen comportarse simultáneamente; Un ejemplo común son los estados de ánimo de los compañeros de cuarto. [19]Para estimar modelos de retroalimentación simultánea, también es necesaria una teoría del equilibrio: que X e Y están en estados relativamente estables o son parte de un sistema (sociedad, mercado, aula) que se encuentra en un estado relativamente estable.

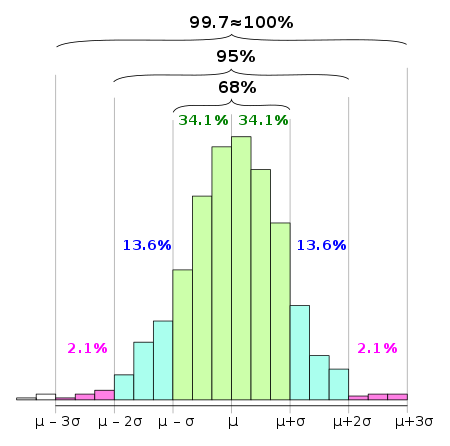

En las estadísticas , la regla 68–95–99.7 , también conocida como regla empírica , es una abreviatura utilizada para recordar el porcentaje de valores que se encuentran dentro de una banda alrededor de la media en una distribución normalcon un ancho de dos, cuatro y seis estándares. desviaciones , respectivamente; con más precisión, 68.27%, 95.45% y 99.73% de los valores se encuentran dentro de una, dos y tres desviaciones estándar de la media, respectivamente.

En notación matemática, estos hechos se pueden expresar de la siguiente manera, donde Χ es una observación de una variable aleatoria normalmente distribuida , μ es la media de la distribución, y σes su desviación estándar:

En las ciencias empíricas, la así llamada regla de tres sigmaexpresa una heurística convencional de que casi todos los valores se consideran dentro de las tres desviaciones estándar de la media, y por lo tanto es empíricamente útil tratar la probabilidad del 99.7% como una certeza. [1] La utilidad de esta heurística depende significativamente de la pregunta en consideración. En las ciencias sociales, un resultado puede considerarse "significativo" si su nivel de confianza es del orden de un efecto de sigma doble (95%), mientras que en la física de partículas , existe una convención de un efecto de sigma cinco (99.99994%). confianza) siendo requeridos para calificar como un descubrimiento .

La "regla de tres sigma" se relaciona con un resultado también conocido como la regla de tres sigma, que establece que incluso para las variables de distribución no normal, al menos el 88.8% de los casos debe estar dentro de intervalos de tres sigma correctamente calculados. Se sigue de la desigualdad de Chebyshev . Para distribuciones unimodales, la probabilidad de estar dentro del intervalo es de al menos el 95%. Puede haber ciertas suposiciones para una distribución que obligue a que esta probabilidad sea al menos del 98%.

Función de distribución acumulativa [ editar ]

Estos valores numéricos "68%, 95%, 99,7%" provienen de la función de distribución acumulativa de la distribución normal .

El intervalo de predicción para cualquier puntaje estándar zcorresponde numéricamente a (1− (1− Φ μ , σ 2 (z)) · 2).

Por ejemplo, Φ (2) ≈ 0.9772 , o Pr ( X ≤ μ + 2 σ ) ≈ 0.9772 , que corresponde a un intervalo de predicción de (1 - (1 - 0.97725) · 2) = 0.9545 = 95.45%. Tenga en cuenta que este no es un intervalo simétrico, es simplemente la probabilidad de que una observación sea menor que μ + 2 σ . Para calcular la probabilidad de que una observación se encuentre dentro de dos desviaciones estándar de la media (pequeñas diferencias debidas al redondeo):

Esto está relacionado con el intervalo de confianza utilizado en las estadísticas: es aproximadamente un intervalo de confianza del 95% cuando Es el promedio de una muestra de tamaño. .

Pruebas de normalidad [ editar ]

La "regla 68-95-99.7" se usa a menudo para obtener rápidamente una estimación de probabilidad aproximada de algo, dada su desviación estándar, si se supone que la población es normal. También se usa como prueba simple para valores atípicos si la población se supone normal, y como prueba de normalidad si la población es potencialmente no normal.

Para pasar de una muestra a una serie de desviaciones estándar, primero se calcula la desviación , ya sea el error o el residuo, dependiendo de si se conoce la media de la población o solo se estima. El siguiente paso es estandarizar (dividir por la desviación estándar de la población), si se conocen los parámetros de la población, o estudiar (dividir por una estimación de la desviación estándar), si los parámetros son desconocidos y solo se estiman.

Para usarlo como prueba de valores atípicos o de normalidad, se calcula el tamaño de las desviaciones en términos de desviaciones estándar y se compara con la frecuencia esperada. Dado un conjunto de muestras, uno puede calcular los residuos estudiados y compararlos con la frecuencia esperada: los puntos que caen más de 3 desviaciones estándar de la norma son probablemente valores atípicos (a menos que el tamaño de la muestrasea significativamente grande, por lo que se espera una muestra de este extremo), y si hay muchos puntos más de 3 desviaciones estándar de la norma, es probable que haya razones para cuestionar la normalidad asumida de la distribución. Esto se mantiene cada vez más fuerte para movimientos de 4 o más desviaciones estándar.

Uno puede calcular de manera más precisa, aproximando el número de movimientos extremos de una magnitud dada o mayor por una distribución de Poisson , pero simplemente, si uno tiene múltiples 4 movimientos de desviación estándar en una muestra de tamaño 1,000, uno tiene una razón sólida para considerar estos valores atípicos o Cuestionar la normalidad asumida de la distribución.

Por ejemplo, un evento 6 σ corresponde a una probabilidad de aproximadamente dos partes por billón . Por ejemplo, si se considera que los eventos ocurren diariamente, esto correspondería a un evento esperado cada 1.4 millones de años. Esto da una prueba de normalidad simple : si uno es testigo de un 6 σ en datos diarios y ha pasado significativamente menos de 1 millón de años, entonces una distribución normal probablemente no proporcione un buen modelo para la magnitud o la frecuencia de grandes desviaciones a este respecto.

En The Black Swan , Nassim Nicholas Taleb da el ejemplo de los modelos de riesgo según los cuales la caída del Black Monday correspondería a un evento 36- σ : la ocurrencia de tal evento debería sugerir instantáneamente que el modelo es defectuoso, es decir, que el proceso bajo La consideración no está modelada satisfactoriamente por una distribución normal. Los modelos refinados deben considerarse, por ejemplo, mediante la introducción de la volatilidad estocástica . En tales discusiones, es importante estar al tanto del problema de la falacia del jugador , que establece que una sola observación de un evento raro no contradice que el evento es de hecho raro [ cita requerida ]. Es la observación de una pluralidad de eventos supuestamente raros que socava cada vez más la hipótesis de que son raros, es decir, la validez del modelo asumido. Un modelo adecuado de este proceso de pérdida gradual de confianza en una hipótesis implicaría la designación de probabilidad previa no solo para la hipótesis en sí, sino para todas las hipótesis alternativas posibles. Por esta razón, las pruebas estadísticas de hipótesis no funcionan tanto confirmando una hipótesis que se considere probable, sino refutando hipótesis que se consideran poco probables .

Tabla de valores numéricos [ editar ]

Debido a las colas exponenciales de la distribución normal, las probabilidades de desviaciones más altas disminuyen muy rápidamente. De las reglas para datos normalmente distribuidos para un evento diario:

| Distancia | Fracción esperada de la población dentro del rango | Frecuencia aproximada esperada fuera del rango | Frecuencia aproximada para evento diario. |

|---|---|---|---|

| μ ± 0.5σ | 0.382 924 922 548 026 | 2 en 3 | Cuatro o cinco veces a la semana. |

| μ ± σ | 0.682 689 492 137 086 | 1 en 3 | Dos veces a la semana |

| μ ± 1.5σ | 0.866 385 597 462 284 | 1 en 7 | Semanal |

| μ ± 2σ | 0.954 499 736 103 642 | 1 en 22 | Cada tres semanas |

| μ ± 2.5σ | 0,987 580 669 348 448 | 1 en 81 | Trimestral |

| μ ± 3σ | 0.997 300 203 936 740 | 1 en 370 | Anual |

| μ ± 3.5σ | 0.999 534 741 841 929 | 1 en 2149 | Cada seis años |

| μ ± 4σ | 0.999 936 657 516 334 | 1 en 15 787 | Cada 43 años (dos veces en la vida) |

| μ ± 4.5σ | 0.999 993 204 653 751 | 1 en 147 160 | Cada 403 años (una vez en la era moderna). |

| μ ± 5σ | 0.999 999 426 696 856 | 1 en 1 744 278 | Cada 4776 años (una vez en la historia registrada) |

| μ ± 5.5σ | 0.999 999 962 020 875 | 1 en 26 330 254 | Cada 72 090 años (tres veces en la historia de la humanidad moderna ) |

| μ ± 6σ | 0.999 999 998 026 825 | 1 en 506 797 346 | Cada 1.38 millones de años (dos veces en la historia de la humanidad ) |

| μ ± 6.5σ | 0.999 999 999 919 680 | 1 en 12 450 197 393 | Cada 34 millones de años (dos veces desde la extinción de los dinosaurios ) |

| μ ± 7σ | 0.999 999 999 997 440 | 1 en 390 682 215 445 | Cada 1.07 mil millones de años (cuatro veces en la historia de la Tierra ) |

| μ ± x σ | 1 en | Cada dias |

No hay comentarios:

Publicar un comentario